Forwarded from Machinelearning

Туториал ориентируется на нетехническую аудиторию, которая имеет опыт взаимодействия с большими языковыми моделями.

В первой половине представлены ментальные конструкции природы посттренинга и промптов. Вторая половина содержит более конкретные предписания и высокоуровневую процедуру промпт-инжиниринга.

Авторы, Varun Godbole и Ellie Pavlick подчеркивают, что поиск «идеальной» подсказки — это итеративный процесс, аналогичный настройке модели, который в лучшем случае является эмпирическим, а в худшем - алхимическим.

@ai_machinelearning_big_data

#AI #ML #LLM #Prompt #Github #Tutorial

Please open Telegram to view this post

VIEW IN TELEGRAM

👍4❤2

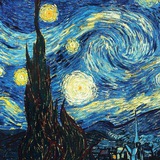

Stable Diffusion 3.5 Prompt Guide: создание лучших промптов

Stability AI опубликовала детальное руководство по работе с Stable Diffusion 3.5, которое поможет генерировать более качественные изображения с минимальными усилиями. ✍️

Что внутри:

- Основы создания промптов: как правильно формулировать запросы.

- Примеры для разных стилей: от реализма до сюрреализма.

- Рекомендации по использованию negative prompts для устранения нежелательных элементов.

- Особенности 3.5-версии: улучшенная обработка текстовых описаний и деталей.

- Советы для настройки параметров, таких как

🔗 [Stable Diffusion 3.5 Prompt Guide](https://stability.ai/learning-hub/stable-diffusion-3-5-prompt-guide?utm_medium)

Stability AI опубликовала детальное руководство по работе с Stable Diffusion 3.5, которое поможет генерировать более качественные изображения с минимальными усилиями. ✍️

Что внутри:

- Основы создания промптов: как правильно формулировать запросы.

- Примеры для разных стилей: от реализма до сюрреализма.

- Рекомендации по использованию negative prompts для устранения нежелательных элементов.

- Особенности 3.5-версии: улучшенная обработка текстовых описаний и деталей.

- Советы для настройки параметров, таких как

CFG Scale, Steps и других. 🔗 [Stable Diffusion 3.5 Prompt Guide](https://stability.ai/learning-hub/stable-diffusion-3-5-prompt-guide?utm_medium)

Stability AI

Stable Diffusion 3.5 Prompt Guide — Stability AI

This guide offers practical prompting tips for Stable Diffusion 3.5, allowing you to refine image concepts quickly and precisely.

👍3

💡 RAG-Diffusion: Трансформация текста и изображений в сложные сцены

### 🔑 Ключевые особенности

- Референсная генерация: Использует изображения и текстовые подсказки для формирования визуально и концептуально согласованных сцен.

- Фрагментарная композиция: Позволяет указывать различные компоненты сцены отдельно, используя несколько текстовых описаний.

- Точные детали: Высокое качество генерации даже при сложных сценах благодаря кросс-энкодеру для мультимодальной фьюзии.

### 🖥️ Применение

- Генерация контента для фильмов, игр и AR/VR-среды.

- Прототипирование сложных визуальных сценариев для дизайнеров.

- Использование в мультимодальных поисковых системах.

🔗 [GitHub](https://github.com/NJU-PCALab/RAG-Diffusion)

### 🔑 Ключевые особенности

- Референсная генерация: Использует изображения и текстовые подсказки для формирования визуально и концептуально согласованных сцен.

- Фрагментарная композиция: Позволяет указывать различные компоненты сцены отдельно, используя несколько текстовых описаний.

- Точные детали: Высокое качество генерации даже при сложных сценах благодаря кросс-энкодеру для мультимодальной фьюзии.

### 🖥️ Применение

- Генерация контента для фильмов, игр и AR/VR-среды.

- Прототипирование сложных визуальных сценариев для дизайнеров.

- Использование в мультимодальных поисковых системах.

🔗 [GitHub](https://github.com/NJU-PCALab/RAG-Diffusion)

👍3❤1

⚡ FLUX: расширение инструментов для генерации и редактирования изображений ⚡

Black Forest Labs представили

### 🚀 Состав набора:

- FLUX.1 Fill

Инструмент для inpainting и outpainting. Позволяет дополнять или перерисовывать части изображения с высокой точностью.

- FLUX.1 Depth и FLUX.1 Canny

Модули ControlNet для управления глубиной и контурами изображений. Доступны в формате LoRA для легковесной и удобной интеграции.

- FLUX.1 Redux

IP-адаптер, обеспечивающий управление стилем и деталями изображения. Полезен для гибкой кастомизации результатов генерации.

🔗 [Подробнее о FLUX](https://blackforestlabs.ai/flux-1-tools/)

🔗 [Репозиторий на GitHub](https://github.com/black-forest-labs/flux)

Black Forest Labs представили

### 🚀 Состав набора:

- FLUX.1 Fill

Инструмент для inpainting и outpainting. Позволяет дополнять или перерисовывать части изображения с высокой точностью.

- FLUX.1 Depth и FLUX.1 Canny

Модули ControlNet для управления глубиной и контурами изображений. Доступны в формате LoRA для легковесной и удобной интеграции.

- FLUX.1 Redux

IP-адаптер, обеспечивающий управление стилем и деталями изображения. Полезен для гибкой кастомизации результатов генерации.

🔗 [Подробнее о FLUX](https://blackforestlabs.ai/flux-1-tools/)

🔗 [Репозиторий на GitHub](https://github.com/black-forest-labs/flux)

Generative Ai

⚡ FLUX: расширение инструментов для генерации и редактирования изображений ⚡ Black Forest Labs представили ### 🚀 Состав набора: - FLUX.1 Fill Инструмент для inpainting и outpainting. Позволяет дополнять или перерисовывать части изображения с высокой…

💡 ComfyUI: моментальная поддержка FLUX-инструментов 💡

Команда ComfyUI уже внедрила обновления! Теперь пользователи ComfyUI могут легко интегрировать FLUX.1 Fill, Depth, Canny и Redux для улучшения своих рабочих процессов.

### 🔑 Что нового?

- Поддержка FLUX.1 Fill

Расширение возможностей inpainting и outpainting для точного редактирования изображений прямо в интерфейсе ComfyUI.

- Контур и глубина (Depth/Canny)

Используйте FLUX.1 Depth и FLUX.1 Canny для работы с глубинными картами и контурами. Полная интеграция модулей ControlNet позволяет работать с этими инструментами на лету.

- IP-адаптер (FLUX.1 Redux)

Новый уровень контроля стиля и детализации изображения теперь доступен прямо в ComfyUI.

### 🛠️ Преимущества интеграции:

- Удобная настройка инструментов через графический интерфейс ComfyUI.

- Полная поддержка LoRA для глубины и контуров.

- Быстрый старт без необходимости сложной настройки.

С этим обновлением ComfyUI становится еще мощнее для профессиональной генерации изображений!

🔗 [Подробнее о поддержке FLUX в ComfyUI](https://blog.comfy.org/day-1-support-for-flux-tools-in-comfyui/)

Команда ComfyUI уже внедрила обновления! Теперь пользователи ComfyUI могут легко интегрировать FLUX.1 Fill, Depth, Canny и Redux для улучшения своих рабочих процессов.

### 🔑 Что нового?

- Поддержка FLUX.1 Fill

Расширение возможностей inpainting и outpainting для точного редактирования изображений прямо в интерфейсе ComfyUI.

- Контур и глубина (Depth/Canny)

Используйте FLUX.1 Depth и FLUX.1 Canny для работы с глубинными картами и контурами. Полная интеграция модулей ControlNet позволяет работать с этими инструментами на лету.

- IP-адаптер (FLUX.1 Redux)

Новый уровень контроля стиля и детализации изображения теперь доступен прямо в ComfyUI.

### 🛠️ Преимущества интеграции:

- Удобная настройка инструментов через графический интерфейс ComfyUI.

- Полная поддержка LoRA для глубины и контуров.

- Быстрый старт без необходимости сложной настройки.

С этим обновлением ComfyUI становится еще мощнее для профессиональной генерации изображений!

🔗 [Подробнее о поддержке FLUX в ComfyUI](https://blog.comfy.org/day-1-support-for-flux-tools-in-comfyui/)

blog.comfy.org

Day 1 Support for Flux Tools in ComfyUI

We’re thrilled to share that ComfyUI now supports 3 series of new models from Black Forest Labs designed for Flux.1: the Redux Adapter, Fill Model, ControlNet Models & LoRAs (Depth and Canny).

🔥2

🚀 Sana: новая модель для генерации 4K-изображений от NVIDIA 🚀

Sana — революционная генеративная модель от NVIDIA, обеспечивающая эффективную генерацию изображений высокого разрешения (до 4K) благодаря инновационной архитектуре.

### 🔑 Ключевые компоненты:

- 🟢 Deep Compression Autoencoder (DC-AE)

Сжимает изображение в 32 раза, минимизируя число латентных токенов. Это ускоряет обучение и делает возможной генерацию изображений сверхвысокого разрешения.

- 🟢 Linear Diffusion Transformer (Linear DiT)

Использует линейное внимание вместо традиционного, ускоряя генерацию 4K-изображений в 1.7 раза. Вместо стандартного MLP-FFN применяет Mix-FFN (свёртка 3x3 и Gated Linear Unit), что позволяет отказаться от позиционного кодирования без потери качества.

- 🟢 Decoder-only Small LLM as Text Encoder

Основан на LLM Gemma, что улучшает интерпретацию текстовых запросов. Точные и понятные описания пользователя преобразуются в реалистичные визуальные результаты.

### 🎨 Почему Sana?

1. Оптимизация генерации: Быстрее, меньше вычислительных затрат, без снижения качества.

2. 4K-графика: Полный контроль над деталями изображения.

3. Интеллектуальный текстовый энкодер: Максимально точный перенос задумки пользователя в изображение.

🔗 [Демо и описание модели Sana](https://nvlabs.github.io/Sana/)

Sana — революционная генеративная модель от NVIDIA, обеспечивающая эффективную генерацию изображений высокого разрешения (до 4K) благодаря инновационной архитектуре.

### 🔑 Ключевые компоненты:

- 🟢 Deep Compression Autoencoder (DC-AE)

Сжимает изображение в 32 раза, минимизируя число латентных токенов. Это ускоряет обучение и делает возможной генерацию изображений сверхвысокого разрешения.

- 🟢 Linear Diffusion Transformer (Linear DiT)

Использует линейное внимание вместо традиционного, ускоряя генерацию 4K-изображений в 1.7 раза. Вместо стандартного MLP-FFN применяет Mix-FFN (свёртка 3x3 и Gated Linear Unit), что позволяет отказаться от позиционного кодирования без потери качества.

- 🟢 Decoder-only Small LLM as Text Encoder

Основан на LLM Gemma, что улучшает интерпретацию текстовых запросов. Точные и понятные описания пользователя преобразуются в реалистичные визуальные результаты.

### 🎨 Почему Sana?

1. Оптимизация генерации: Быстрее, меньше вычислительных затрат, без снижения качества.

2. 4K-графика: Полный контроль над деталями изображения.

3. Интеллектуальный текстовый энкодер: Максимально точный перенос задумки пользователя в изображение.

🔗 [Демо и описание модели Sana](https://nvlabs.github.io/Sana/)

❤3👎1

🔉 Crisper Whisperer: новая версия Whisper с акцентом на сверхточную транскрипцию речи 🎙️

Crisper Whisperer — это обновлённая модель на базе Whisper Large-V2, оптимизированная для максимальной точности автоматического распознавания речи (ASR). Она выделяется способностью фиксировать даже мельчайшие детали произнесённого текста: вводные слова, паузы, заикания и эмоциональные нюансы.

📌 Особенности

- 🏆 Точность на уровне лидеров рынка: входит в топ открытого ASR-лидерборда Hugging Face.

- 💬 Подробная транскрипция: передаёт все звуковые детали речи, вплоть до междометий.

- 🔧 Фокус на real-world применениях: идеально для задач, где нужна 100% передача смысла (медицина, стенография, юридические записи).

- 📈 Оптимизация под практическое использование: снижены ресурсоёмкость и увеличена стабильность.

🔗 [Модель и чекпоинты](https://huggingface.co/nyrahealth/CrisperWhisper)

🔗 [ASR-лидерборд](https://huggingface.co/spaces/hf-audio/open_asr_leaderboard)

Crisper Whisperer — это обновлённая модель на базе Whisper Large-V2, оптимизированная для максимальной точности автоматического распознавания речи (ASR). Она выделяется способностью фиксировать даже мельчайшие детали произнесённого текста: вводные слова, паузы, заикания и эмоциональные нюансы.

📌 Особенности

- 🏆 Точность на уровне лидеров рынка: входит в топ открытого ASR-лидерборда Hugging Face.

- 💬 Подробная транскрипция: передаёт все звуковые детали речи, вплоть до междометий.

- 🔧 Фокус на real-world применениях: идеально для задач, где нужна 100% передача смысла (медицина, стенография, юридические записи).

- 📈 Оптимизация под практическое использование: снижены ресурсоёмкость и увеличена стабильность.

🔗 [Модель и чекпоинты](https://huggingface.co/nyrahealth/CrisperWhisper)

🔗 [ASR-лидерборд](https://huggingface.co/spaces/hf-audio/open_asr_leaderboard)

huggingface.co

nyrahealth/CrisperWhisper · Hugging Face

We’re on a journey to advance and democratize artificial intelligence through open source and open science.

🔥5👎1

This media is not supported in your browser

VIEW IN TELEGRAM

🚀 LTX Video: генерация видео

Lightricks представили LTX Video (LTXV) — open-source модель для генерации видео, работающую быстрее воспроизведения. В основе технологии — энкодер с коэффициентом сжатия 1:192, обеспечивающий высокую согласованность движения.

### 🔑 Основные характеристики:

- 5 секунд видео (121 кадр, 768x512) за 2.5 секунды (20 шагов диффузии на H100).

- Компактная модель (2B параметров): отличные результаты без массивных архитектур.

- Оптимизация для GPU/TPU с PyTorch XLA.

- Эффективная работа на потребительских GPU (например, RTX 4090).

### 📌 Ресурсы:

- [GitHub](https://github.com/Lightricks/LTX-Video)

- [Hugging Face](https://huggingface.co/Lightricks/LTX-Video)

- [ComfyUI Nodes](https://github.com/Lightricks/ComfyUI-LTXVideo)

- [Playground](https://huggingface.co/spaces/Lightricks/LTX-Video-Playground)

🔗 [Подробнее на сайте Lightricks](https://www.lightricks.com/ltxv)

Lightricks представили LTX Video (LTXV) — open-source модель для генерации видео, работающую быстрее воспроизведения. В основе технологии — энкодер с коэффициентом сжатия 1:192, обеспечивающий высокую согласованность движения.

### 🔑 Основные характеристики:

- 5 секунд видео (121 кадр, 768x512) за 2.5 секунды (20 шагов диффузии на H100).

- Компактная модель (2B параметров): отличные результаты без массивных архитектур.

- Оптимизация для GPU/TPU с PyTorch XLA.

- Эффективная работа на потребительских GPU (например, RTX 4090).

### 📌 Ресурсы:

- [GitHub](https://github.com/Lightricks/LTX-Video)

- [Hugging Face](https://huggingface.co/Lightricks/LTX-Video)

- [ComfyUI Nodes](https://github.com/Lightricks/ComfyUI-LTXVideo)

- [Playground](https://huggingface.co/spaces/Lightricks/LTX-Video-Playground)

🔗 [Подробнее на сайте Lightricks](https://www.lightricks.com/ltxv)

🔥4👍1

Andrew Ng представил библиотеку aisuite для работы с LLM

aisuite — новая open-source Python-библиотека, упрощающая интеграцию с различными провайдерами LLM (Large Language Models). Теперь вы можете переключаться между моделями разных поставщиков, просто изменяя одну строку.

Ключевые возможности

- Единый интерфейс: Упрощает работу с моделями OpenAI (`openai:gpt-4o`), Anthropic (`anthropic:claude-3-5-sonnet`), Ollama (`ollama:llama3.1:8b`) и другими.

- Гибкость: Быстрая замена модели через строковый идентификатор.

- Легкий старт: Установка одной командой:

https://github.com/andrewyng/aisuite

aisuite — новая open-source Python-библиотека, упрощающая интеграцию с различными провайдерами LLM (Large Language Models). Теперь вы можете переключаться между моделями разных поставщиков, просто изменяя одну строку.

Ключевые возможности

- Единый интерфейс: Упрощает работу с моделями OpenAI (`openai:gpt-4o`), Anthropic (`anthropic:claude-3-5-sonnet`), Ollama (`ollama:llama3.1:8b`) и другими.

- Гибкость: Быстрая замена модели через строковый идентификатор.

- Легкий старт: Установка одной командой:

pip install aisuite

https://github.com/andrewyng/aisuite

GitHub

GitHub - andrewyng/aisuite: Simple, unified interface to multiple Generative AI providers

Simple, unified interface to multiple Generative AI providers - GitHub - andrewyng/aisuite: Simple, unified interface to multiple Generative AI providers

👍2

🤖 Anthropic предлагает новый способ интеграции данных с AI-чатботами

Компания Anthropic представила метод подключения внешних данных к AI-чатботам, таких как Claude, с упором на приватность и контроль. Эта система позволяет чатботу извлекать данные из подключенных источников (например, корпоративных баз данных или облачных систем), минимизируя риск утечек.

### 🚀 Основные особенности:

- Локальный доступ к данным: данные остаются на стороне пользователя и предоставляются AI только по запросу, что повышает безопасность.

- Гибкая настройка доступа: можно регулировать, какие данные доступны и в каких пределах.

- Обновление информации в реальном времени: чатботы могут работать с актуальными данными, предоставляя пользователям контекстуальные и точные ответы.

- Применение в бизнесе: подходит для автоматизации процессов, поддержки клиентов и работы с конфиденциальной информацией.

Anthropic делает акцент на этичном использовании AI, избегая рисков, связанных с централизованным хранением пользовательских данных.

🔗 [Читать на TechCrunch](https://techcrunch.com/2024/11/25/anthropic-proposes-a-way-to-connect-data-to-ai-chatbots/)

Компания Anthropic представила метод подключения внешних данных к AI-чатботам, таких как Claude, с упором на приватность и контроль. Эта система позволяет чатботу извлекать данные из подключенных источников (например, корпоративных баз данных или облачных систем), минимизируя риск утечек.

### 🚀 Основные особенности:

- Локальный доступ к данным: данные остаются на стороне пользователя и предоставляются AI только по запросу, что повышает безопасность.

- Гибкая настройка доступа: можно регулировать, какие данные доступны и в каких пределах.

- Обновление информации в реальном времени: чатботы могут работать с актуальными данными, предоставляя пользователям контекстуальные и точные ответы.

- Применение в бизнесе: подходит для автоматизации процессов, поддержки клиентов и работы с конфиденциальной информацией.

Anthropic делает акцент на этичном использовании AI, избегая рисков, связанных с централизованным хранением пользовательских данных.

🔗 [Читать на TechCrunch](https://techcrunch.com/2024/11/25/anthropic-proposes-a-way-to-connect-data-to-ai-chatbots/)

TechCrunch

Anthropic proposes a new way to connect data to AI chatbots | TechCrunch

Anthropic is proposing a new standard for connecting AI assistants to the systems where data lives, called Model Context Protocol (MCP).

🎙️ OuteTTS-0.2-500M: обновление TTS-модели с улучшенным клонированием голоса

OuteTTS-0.2-500M — новая версия модели синтеза речи, основанная на Qwen-2.5-0.5B. Обучена на улучшенных датасетах (Emilia-Dataset, LibriTTS-R, Multilingual LibriSpeech) с поддержкой контекста до 4096 токенов (~54 секунды звука).

### Что нового?

🟢 Точность: Более согласованное следование промптам.

🟢 Натуральность: Ещё более естественная и плавная речь.

🟢 Словарь: Тренировка на 5+ млрд аудио-токенов.

🟢 Клонирование голоса: Точность и вариативность улучшены.

🟢 Многоязычность: Поддержка китайского, японского и корейского языков (экспериментально).

https://www.outeai.com/blog/outetts-0.2-500m

https://huggingface.co/OuteAI/OuteTTS-0.2-500M

OuteTTS-0.2-500M — новая версия модели синтеза речи, основанная на Qwen-2.5-0.5B. Обучена на улучшенных датасетах (Emilia-Dataset, LibriTTS-R, Multilingual LibriSpeech) с поддержкой контекста до 4096 токенов (~54 секунды звука).

### Что нового?

🟢 Точность: Более согласованное следование промптам.

🟢 Натуральность: Ещё более естественная и плавная речь.

🟢 Словарь: Тренировка на 5+ млрд аудио-токенов.

🟢 Клонирование голоса: Точность и вариативность улучшены.

🟢 Многоязычность: Поддержка китайского, японского и корейского языков (экспериментально).

https://www.outeai.com/blog/outetts-0.2-500m

https://huggingface.co/OuteAI/OuteTTS-0.2-500M

Forwarded from эйай ньюз

This media is not supported in your browser

VIEW IN TELEGRAM

Hunyuan Video - новый опенсорс 13B видео генератор от Tencent

Качество офигенное, даже для 13B модели, хоть и генерировать может максимум пять секунд. Но, самое главное - доступны веса.

Генерится 129 кадров, что как раз чуть больше 5 сек в 24 fps.

По архитектуре: используют Temporal VAE с 16 каналами и 4x даунсеплингом по времени, то есть это 32 latent frame'а. То есть автоэнкодер не самый навороченный – в других моделях и видео и 128 каналов и более агрессивный даунсемплинг по времени.

Сама модель очень похожа на Flux, где сначала идут two-stream блоки как в SD3, где картиночные и текстовые токены обрабатываются параллельно, а затем идёт серия обычных DiT блоков.

В качестве текстового энкодера используют Clip и Multimodal LLM (llava-llama-3-8b) вместо традиционного T5. Говорят, что с MLLM у них достигается боле качественный prompt alignment.

Чтобы запустить модель нужно минимум 45 гигабайт видеопамяти для 544x960 видео и 60 гигов для 720p. Умельцы явно подкрутят и оптимизируют модельку, так что запуск на консьюмерских видюхах на низком разрешении не исключён.

Статья занятная, стоит прочитать в деталях.

Я пока сам их моделью ничего не генерил, но предполагаю, что одно видео будет генерится минут 10.

Демка (нужен китайский номер)

Веса

Пейпер

@ai_newz

Качество офигенное, даже для 13B модели, хоть и генерировать может максимум пять секунд. Но, самое главное - доступны веса.

Генерится 129 кадров, что как раз чуть больше 5 сек в 24 fps.

По архитектуре: используют Temporal VAE с 16 каналами и 4x даунсеплингом по времени, то есть это 32 latent frame'а. То есть автоэнкодер не самый навороченный – в других моделях и видео и 128 каналов и более агрессивный даунсемплинг по времени.

Сама модель очень похожа на Flux, где сначала идут two-stream блоки как в SD3, где картиночные и текстовые токены обрабатываются параллельно, а затем идёт серия обычных DiT блоков.

В качестве текстового энкодера используют Clip и Multimodal LLM (llava-llama-3-8b) вместо традиционного T5. Говорят, что с MLLM у них достигается боле качественный prompt alignment.

Чтобы запустить модель нужно минимум 45 гигабайт видеопамяти для 544x960 видео и 60 гигов для 720p. Умельцы явно подкрутят и оптимизируют модельку, так что запуск на консьюмерских видюхах на низком разрешении не исключён.

Статья занятная, стоит прочитать в деталях.

Я пока сам их моделью ничего не генерил, но предполагаю, что одно видео будет генерится минут 10.

Демка (нужен китайский номер)

Веса

Пейпер

@ai_newz

🔥3

Forwarded from Machinelearning

PydanticAI - фреймворк для Python, созданный командой разработчиков Pydantic, который упрощает создание приложений с использованием LLM. Фреймворк имеет простой и интуитивно понятный интерфейс для взаимодействия с LLMs, поддерживающими Async OpenAI (Ollama) и openAI API (ChatGPT, Gemini и Groq), с поддержкой Anthropic в ближайшем будущем.

Основная особенность PydanticAI - система внедрения зависимостей, которая передает данные, соединения и логику в целевую модель. Она упрощает тестирование и оценку агентов и позволяет динамически формировать системные промпты и определять инструменты, доступные LLM.

PydanticAI имеет возможность потоковой обработки ответов с валидацией структурированных данных, позволяя контролировать корректность соответствие данных ожидаемому ответу, тем самым повышая эффективность и интерактивность приложений.

Для отладки и мониторинга работы агентов предусмотрена интеграция с Pydantic Logfire, с которым можно отслеживать запросы к базам данных, анализировать поведение модели и оценивать производительность.

⚠️ PydanticAI находится на ранней стадии бета-тестирования.

# Install via PyPI

pip install pydantic-ai

# Set Gemini API key

export GEMINI_API_KEY=your-api-key

# Run example

from pydantic_ai import Agent

agent = Agent(

'gemini-1.5-flash',

system_prompt='Be concise, reply with one sentence.',

)

result = agent.run_sync('Where does "hello world" come from?')

print(result.data)

"""

The first known use of "hello, world" was in a 1974 textbook about the C programming language.

"""

@ai_machinelearning_big_data

#AI #ML #LLM #Agents #Framework #PydanticAI

Please open Telegram to view this post

VIEW IN TELEGRAM

👍3❤1🔥1

Forwarded from Machinelearning

Fish Speech - модель генерации TTS обновилась до версии 1.5. Эта версия обучалась на 1 млн.часов мультиязычных аудиоданных и заняла 2 место в бенчмарке TTS-Arena (как "Anonymous Sparkle").

Заявлена задержка <150 мс с высококачественным мгновенным клонированием голоса.

Fish Speech для локального инференса требует 4Gb GPU и 8 BG GPU для файнтюна. Запуск возможен на MacOS, Linux и Windows в режимах CLI, GUI и WebUI и Docker.

Подробные инструкции по установке, инференсу в различных режимах для каждой платформы, туториал по файнтюну и примеры доступны в документации проекта Fish Speech.

⚠️ Репозиторий на Github еще не обновлен информацией о версии 1.5, а официальное демо от разработчиков поддерживает синтез только на английском, китайском и японском.

@ai_machinelearning_big_data

#AI #ML #TTS #FIshSpeech

Please open Telegram to view this post

VIEW IN TELEGRAM

🔥5❤1👍1

🎥 Sora: Новая текст-видео AI-модель от OpenAI

OpenAI объявила о запуске Sora — передовой модели для генерации видео по текстовым подсказкам.

### Ключевые особенности Sora

- 📝 Преобразование текста в видео: Модель принимает текстовые описания и генерирует короткие видео с реалистичными и стилизованными визуальными эффектами.

- 🎨 Широкий спектр стилей: Возможность выбора между реалистичными видео, мультяшными стилями и другими творческими визуальными решениями.

- 🔄 Стабильность последовательностей: Алгоритмы оптимизированы для сохранения плавности и логической согласованности движения объектов на видео.

- 🚀 Высокая скорость генерации: Ускоренные вычисления позволяют получать результаты быстрее по сравнению с предыдущими текст-видео моделями.

- 🛠️ Модульная интеграция: Sora легко встраивается в креативные процессы или корпоративные пайплайны благодаря API и гибким настройкам.

### Технологические новшества

Sora использует диффузионные модели нового поколения, которые объединяют высокую скорость генерации с улучшенной визуальной точностью. Для временной стабильности и детализации движения применяются специальные алгоритмы сглаживания динамики.

### Доступ и ограничения

- 🔑 Требуется учетная запись OpenAI: Доступ предоставляется через официальный интерфейс OpenAI (API или веб-платформа).

- 💵 Платный доступ: Модель предполагает коммерческую модель монетизации с оплатой за использование API. Детали тарифов уточняются.

- 🌍 Ограничения по регионам: Sora доступна только в странах, где OpenAI предоставляет свои сервисы.

### Этические рамки

- ⚠️ Контроль контента: Генерация запрещена для создания материалов, нарушающих законы, включая дезинформацию, вредоносный или неприемлемый контент.

- 🔍 Модерация: OpenAI внедрила строгие механизмы модерации, чтобы предотвращать злоупотребления моделью.

- 📜 Соответствие политике: Пользователи обязаны соблюдать политику использования, опубликованную на сайте OpenAI.

### Ограничения по генерации

- 🖼️ Максимальная длина видео: На начальном этапе Sora поддерживает короткие видео (до 30 секунд).

### Использование в бизнесе

Для корпоративных клиентов доступны дополнительные функции:

- 🛠️ Гибкая настройка: Адаптация модели под задачи компании.

- 📑 Лицензионные соглашения: Возможна покупка лицензии на использование модели в крупных проектах.

### Применение

Модель подходит для:

- Создания анимаций и рекламных роликов.

- Образовательных видео и презентаций.

- Прототипирования игровых сцен.

- Генерации контента для социальных сетей и платформ.

https://sora.com/

OpenAI объявила о запуске Sora — передовой модели для генерации видео по текстовым подсказкам.

### Ключевые особенности Sora

- 📝 Преобразование текста в видео: Модель принимает текстовые описания и генерирует короткие видео с реалистичными и стилизованными визуальными эффектами.

- 🎨 Широкий спектр стилей: Возможность выбора между реалистичными видео, мультяшными стилями и другими творческими визуальными решениями.

- 🔄 Стабильность последовательностей: Алгоритмы оптимизированы для сохранения плавности и логической согласованности движения объектов на видео.

- 🚀 Высокая скорость генерации: Ускоренные вычисления позволяют получать результаты быстрее по сравнению с предыдущими текст-видео моделями.

- 🛠️ Модульная интеграция: Sora легко встраивается в креативные процессы или корпоративные пайплайны благодаря API и гибким настройкам.

### Технологические новшества

Sora использует диффузионные модели нового поколения, которые объединяют высокую скорость генерации с улучшенной визуальной точностью. Для временной стабильности и детализации движения применяются специальные алгоритмы сглаживания динамики.

### Доступ и ограничения

- 🔑 Требуется учетная запись OpenAI: Доступ предоставляется через официальный интерфейс OpenAI (API или веб-платформа).

- 💵 Платный доступ: Модель предполагает коммерческую модель монетизации с оплатой за использование API. Детали тарифов уточняются.

- 🌍 Ограничения по регионам: Sora доступна только в странах, где OpenAI предоставляет свои сервисы.

### Этические рамки

- ⚠️ Контроль контента: Генерация запрещена для создания материалов, нарушающих законы, включая дезинформацию, вредоносный или неприемлемый контент.

- 🔍 Модерация: OpenAI внедрила строгие механизмы модерации, чтобы предотвращать злоупотребления моделью.

- 📜 Соответствие политике: Пользователи обязаны соблюдать политику использования, опубликованную на сайте OpenAI.

### Ограничения по генерации

- 🖼️ Максимальная длина видео: На начальном этапе Sora поддерживает короткие видео (до 30 секунд).

### Использование в бизнесе

Для корпоративных клиентов доступны дополнительные функции:

- 🛠️ Гибкая настройка: Адаптация модели под задачи компании.

- 📑 Лицензионные соглашения: Возможна покупка лицензии на использование модели в крупных проектах.

### Применение

Модель подходит для:

- Создания анимаций и рекламных роликов.

- Образовательных видео и презентаций.

- Прототипирования игровых сцен.

- Генерации контента для социальных сетей и платформ.

https://sora.com/

Sora

Transform text and images into immersive videos. Animate stories, visualize ideas, and bring your concepts to life.

Forwarded from Denis Sexy IT 🤖

Что показали сегодня, анонсы в основном для разработчиков:

- O1 модели теперь поддерживают строгие JSON схемы на выходе (и это не повлияет на качество работы модели) и Functions calling (это когда модель должна выбрать какой-то скрипт сама по себе во время ответа), фичи которые давно есть у других моделей OpenAI

- Упомянули «Developers Messages» для O1 — штука, которая позволяет разработчиком «направить» модель в нужную сторону в процессе ответа, что-то вроде второго системного промпта, но слабее

- «Reasoning Effort» — вы теперь можете указать сколько времени O1-модель будет «размышлять» перед тем как ответить, ответы будут лучше, но дороже или можно запретить ей слишком много думать перед ответом пользователю

- O1 API теперь поддерживает картинки на вход

- Advanced Voice Mode API теперь работает с WebRTC, то есть голосового ассистента OpenAI будет проще встраивать на веб-страницы без особых мучений (12 строк кода и готово)

- Наконец-то цены на Advanced Voice Mode API понизили на 60%, и теперь доступна новая, в 10 раз дешевле, mini-аудио моделька

- Показали новый способ файнтюна моделей «Prefence Finetuning» — можно тренировать на парах данных, что нравится и не нравится в ответе модели, доступно с сегодня для gpt4o & gpt4o-mini

- Вышли новые SDK — для Go и для Java

Если честно затянуто немного со всеми этими днями, я бы списком почитал уже, еще 3 дня осталось

- O1 модели теперь поддерживают строгие JSON схемы на выходе (и это не повлияет на качество работы модели) и Functions calling (это когда модель должна выбрать какой-то скрипт сама по себе во время ответа), фичи которые давно есть у других моделей OpenAI

- Упомянули «Developers Messages» для O1 — штука, которая позволяет разработчиком «направить» модель в нужную сторону в процессе ответа, что-то вроде второго системного промпта, но слабее

- «Reasoning Effort» — вы теперь можете указать сколько времени O1-модель будет «размышлять» перед тем как ответить, ответы будут лучше, но дороже или можно запретить ей слишком много думать перед ответом пользователю

- O1 API теперь поддерживает картинки на вход

- Advanced Voice Mode API теперь работает с WebRTC, то есть голосового ассистента OpenAI будет проще встраивать на веб-страницы без особых мучений (12 строк кода и готово)

- Наконец-то цены на Advanced Voice Mode API понизили на 60%, и теперь доступна новая, в 10 раз дешевле, mini-аудио моделька

- Показали новый способ файнтюна моделей «Prefence Finetuning» — можно тренировать на парах данных, что нравится и не нравится в ответе модели, доступно с сегодня для gpt4o & gpt4o-mini

- Вышли новые SDK — для Go и для Java

Если честно затянуто немного со всеми этими днями, я бы списком почитал уже, еще 3 дня осталось

👍4👎1

Forwarded from Machinelearning

Подразделение FAIR компании Марка Цукерберга представила новые исследовательские результаты, направленные на развитие исследований в ИИ, а их открытая публикация должна способствовать ускорению общего прогресса:

Модель обучена с применением нового алгоритма, который позволяет представлять состояния, движения и вознаграждения в едином латентном пространстве. Motivo демонстрирует высокую производительность в сравнении со специализированными методами, превосходит современные подходы неконтролируемого обучения с подкреплением и проявляет устойчивость к изменениям окружающей среды.

Метод добавляет незаметные водяные знаки, устойчивые к редактированию и сжатию, чтобы маркировать и отслеживать происхождение сгенерированных видеоматериалов. Video Seal является развитием предыдущей разработки Audio Seal.

Метод, который постепенно заменяет классическую диффузию и повышает производительность и эффективность обобщения при создании изображений, видео, аудио и 3D-структур.

Он уже применяется в продуктах Movie Gen, Audiobox и Melody Flow, а также в Stable-Diffusion-3, Flux, Fold-Flow и Physical Intelligence Pi_0.

Этот подход позволяет создавать разнообразные и сложные сценарии для обучения LLM. Экспериментальное применение Explore Theory-of-Mind с Llama-3.1 7B привело к увеличению точности на 27 пунктов на тесте ToMi.

Основная идея LCM заключается в том, чтобы отделить рассуждения от представления языка, и она вдохновлена тем, как люди могут планировать высокоуровневые мысли для общения. LCM значительно отличается от типичного LLM. Вместо того чтобы предсказывать следующую лексему, LCM обучается предсказывать следующую концепцию или идею высокого уровня, представленную полным предложением в мультимодальном и многоязычном пространстве эмбедингов.

DBLT превосходит модели на основе токенизаторов по надежности, в среднем на 7 пунктов, и отлично справляется с обработкой longtail и rare sequences of unseen symbols.

Метод, который помогает эффективно хранить и извлекать информацию через специальные "слои памяти" без значительного роста вычислительных затрат. Он позволяет моделям работать лучше и точнее на задачах, связанных с фактами.

Она позволяет легко использовать воспроизводимые автоматические оценки T2I-моделей и поддерживает настройку с использованием пользовательских метрик, датасетов и визуализаций.

@ai_machinelearning_big_data

#AI #ML #FAIR #Digest

Please open Telegram to view this post

VIEW IN TELEGRAM

❤3🔥1

Forwarded from Метаверсище и ИИще (Sergey Tsyptsyn ️️)

This media is not supported in your browser

VIEW IN TELEGRAM

Руй видео.

Вы будете смеяцца, но у нас новая опенсорсная видео модель. Причем image2video.

Ruyi is an image-to-video model capable of generating cinematic-quality videos at a resolution of 768, with a frame rate of 24 frames per second, totaling 5 seconds and 120 frames. It supports lens control and motion amplitude control. Using a RTX 3090 or RTX 4090, you can generate 512 resolution, 120 frames (or 768 resolution, ~72 frames) videos without any loss of quality.

https://github.com/IamCreateAI/Ruyi-Models

Поддержка видеогенерации в Комфи из коробки.

@p0lygon, что будем делать? Когда все это успеть протестировать?

@cgevent

И очень толково оформленный GitHub:

Вы будете смеяцца, но у нас новая опенсорсная видео модель. Причем image2video.

Ruyi is an image-to-video model capable of generating cinematic-quality videos at a resolution of 768, with a frame rate of 24 frames per second, totaling 5 seconds and 120 frames. It supports lens control and motion amplitude control. Using a RTX 3090 or RTX 4090, you can generate 512 resolution, 120 frames (or 768 resolution, ~72 frames) videos without any loss of quality.

https://github.com/IamCreateAI/Ruyi-Models

Поддержка видеогенерации в Комфи из коробки.

@p0lygon, что будем делать? Когда все это успеть протестировать?

@cgevent

И очень толково оформленный GitHub:

Forwarded from Stable Diffusion | Automatic 1111 | ComfiUI

This media is not supported in your browser

VIEW IN TELEGRAM

🎬 LTX VIDEO update 👌

Улучшенная модель и схемы

LTXV 0.9.1

📌 Удаляет артефакты "стробирующей текстуры" и генерирует лучшее движение

📌 Поддержка STG - интегрированная система деградации изображения для улучшенной генерации движения

📌 Улучшенный VAE

📌 Улучшенные подписи изображений для преобразования в видео поток

📎🔥 Модель ltx-video-2b-v0.9.1 СКАЧАТЬ

📎 Clip T5: СКАЧАТЬ

(но можно использовать от flux и sd3)

✅ Схема Image-to-video: ССЫЛКА

✅ Схема Text-to-video: ССЫЛКА

📎 Страница разработчика

🔥 Курс по "ComfyUI"

🔑 Уроки на Boosty

Улучшенная модель и схемы

LTXV 0.9.1

📌 Удаляет артефакты "стробирующей текстуры" и генерирует лучшее движение

📌 Поддержка STG - интегрированная система деградации изображения для улучшенной генерации движения

📌 Улучшенный VAE

📌 Улучшенные подписи изображений для преобразования в видео поток

📎🔥 Модель ltx-video-2b-v0.9.1 СКАЧАТЬ

📎 Clip T5: СКАЧАТЬ

(но можно использовать от flux и sd3)

✅ Схема Image-to-video: ССЫЛКА

✅ Схема Text-to-video: ССЫЛКА

📎 Страница разработчика

🔥 Курс по "ComfyUI"

🔑 Уроки на Boosty

Forwarded from Life2film

Media is too big

VIEW IN TELEGRAM

Сравнил разные движки для генерации видео image2video доступные через api.

Промпт везде стандартный.

Кстати это не совсем правильно для получения хорошего результат лучше знать особенности каждой нейронной сети (сделаем гайд и автопомошник для этого)

Обьективно Kling 1.5pro лучше. Но еще скоро в апи будет доступна версия 1.6 pro.

Эта модель и самая дорогая, 1 видео на 5 секунд по себестоимости выходит 0.65 цента.

Но самая крутая сейчас модель от google (кто бы подумал) и доступа к ней нет у меня… ждем в whaitlist https://labs.google/fx/tools/video-fx

Промпт везде стандартный.

Кстати это не совсем правильно для получения хорошего результат лучше знать особенности каждой нейронной сети (сделаем гайд и автопомошник для этого)

In a bustling warehouse, the spaceship takes shape, gears turning and steam hissing, as the team works tirelessly.

Обьективно Kling 1.5pro лучше. Но еще скоро в апи будет доступна версия 1.6 pro.

Эта модель и самая дорогая, 1 видео на 5 секунд по себестоимости выходит 0.65 цента.

Но самая крутая сейчас модель от google (кто бы подумал) и доступа к ней нет у меня… ждем в whaitlist https://labs.google/fx/tools/video-fx

🔥3👍2