Training Language Models to Self-Correct via Reinforcement Learning https://arxiv.org/abs/2409.12917

arXiv.org

Training Language Models to Self-Correct via Reinforcement Learning

Self-correction is a highly desirable capability of large language models (LLMs), yet it has consistently been found to be largely ineffective in modern LLMs. Current methods for training...

👍1🔥1

Forwarded from Kali Novskaya

🌸Больше языков для LLM🌸

#nlp #про_nlp

Huggingface в поиске контрибьюторов носителей языков!

Корпус FineWeb на 15 трлн токенов теперь ждёт большое расширение на 1000+ языков 🎉

🟣 Сколько языков сейчас представлены в практике моделирования языка?

Если считать, что в целом живых языков 6-7 тысяч,

— в базе Ethnologue 7164

— суммарно во всех LLM работах упоминается примерно 1500 языков (в основном за счет работ NLLB и Towards MT for next 1000 languages)

— у звучащей речи чуть лучше: 4000 языков, но у 70% из них меньше чем 2 часа записей (за счет XEUS)

🟣 Бутылочное горлышко валидации

Все ресурсы, которые так или иначе языки описывают, можно расположить на 2 осях координат: их качество и их пригодность для ML-применений. Окажется, что наиболее доступные и пригодные для предобучения моделей корпуса (CommonCrawl, его вариации) в то же время оказываются и наименее качественными.

Причина тому — автоматическое определение языка (см fasttext) невозможность ручной валидации. Автоматические быстрые классификаторы как правило могут с высоким уровнем надежности определить не более 200 языков, тогда как большинство языков оказывается в большой куче "мусора" — наименее надежно атрибутированных данных.

Бутылочное горлышко для того, чтобы побороть валидацию на большом объеме данных — это наличие сообщества носителей языков, которые бы активно контрибьютили и помогали улучшить как классификаторы, так и способы оценки качества получаемых языковых моделей.

Я уже несколько раз рассказывала про ситуацию с многоязычными данными, и даже несколько раз за этот год меняла слайды — так быстро меняется ситуация! И сегодня даже в лучшую сторону.

🟣 Инициатива HuggingFace

Помимо расширения корпуса FineWeb, HuggingFace ищет волонтеров и носителей языка, чтобы расширить именно процедуру многоязычной оценки языковых моделей.

Новая инициатива — FineTasks — объединяет 4 стандартных бенчмарк-формата:

— Машинное чтение: Понимание предоставленного контекста и ответы на вопросы на его основе.

— Общие знания: Ответы на вопросы о фактах из различных областей без дополнительного контекста.

— Понимание естественного языка (NLU): Понимание семантики предоставленного ввода.

— Рассуждения на основе здравого смысла: Демонстрация способности выполнять простые рассуждения, требующие воплощенных знаний.

— Генеративные задачи: Умение генерировать корректный текст на целевом языке.

Авторы уже собрали 185 задач для 9 языков: поддерживаются

китайский, французский, арабский, русский, тайский, хинди, турецкий, суахили и телугу.

Цель для полного бенчмарка — как минимум 50 языков из разных семей, ареалов и с разной письменностью.

Ну и... ждём большой новый многоязычный корпус с открытой лицензией!

Куда контрибьютить?

🟣 Контрибьютить новые задания и языки можно здесь в шаблоне

🟣 Мини-гайд

🟣 Блог HF

#nlp #про_nlp

Huggingface в поиске контрибьюторов носителей языков!

Корпус FineWeb на 15 трлн токенов теперь ждёт большое расширение на 1000+ языков 🎉

Если считать, что в целом живых языков 6-7 тысяч,

— в базе Ethnologue 7164

— суммарно во всех LLM работах упоминается примерно 1500 языков (в основном за счет работ NLLB и Towards MT for next 1000 languages)

— у звучащей речи чуть лучше: 4000 языков, но у 70% из них меньше чем 2 часа записей (за счет XEUS)

Все ресурсы, которые так или иначе языки описывают, можно расположить на 2 осях координат: их качество и их пригодность для ML-применений. Окажется, что наиболее доступные и пригодные для предобучения моделей корпуса (CommonCrawl, его вариации) в то же время оказываются и наименее качественными.

Причина тому — автоматическое определение языка (см fasttext) невозможность ручной валидации. Автоматические быстрые классификаторы как правило могут с высоким уровнем надежности определить не более 200 языков, тогда как большинство языков оказывается в большой куче "мусора" — наименее надежно атрибутированных данных.

Бутылочное горлышко для того, чтобы побороть валидацию на большом объеме данных — это наличие сообщества носителей языков, которые бы активно контрибьютили и помогали улучшить как классификаторы, так и способы оценки качества получаемых языковых моделей.

Я уже несколько раз рассказывала про ситуацию с многоязычными данными, и даже несколько раз за этот год меняла слайды — так быстро меняется ситуация! И сегодня даже в лучшую сторону.

Помимо расширения корпуса FineWeb, HuggingFace ищет волонтеров и носителей языка, чтобы расширить именно процедуру многоязычной оценки языковых моделей.

Новая инициатива — FineTasks — объединяет 4 стандартных бенчмарк-формата:

— Машинное чтение: Понимание предоставленного контекста и ответы на вопросы на его основе.

— Общие знания: Ответы на вопросы о фактах из различных областей без дополнительного контекста.

— Понимание естественного языка (NLU): Понимание семантики предоставленного ввода.

— Рассуждения на основе здравого смысла: Демонстрация способности выполнять простые рассуждения, требующие воплощенных знаний.

— Генеративные задачи: Умение генерировать корректный текст на целевом языке.

Авторы уже собрали 185 задач для 9 языков: поддерживаются

китайский, французский, арабский, русский, тайский, хинди, турецкий, суахили и телугу.

Цель для полного бенчмарка — как минимум 50 языков из разных семей, ареалов и с разной письменностью.

Ну и... ждём большой новый многоязычный корпус с открытой лицензией!

Куда контрибьютить?

Please open Telegram to view this post

VIEW IN TELEGRAM

Telegram

Kali Novskaya

Кстати, пока я пост писала, там HuggingFace треснул и упал:

HF выложили датасет на 15 триллионов токенов — FineWeb 🍷— отфильтрованный моноязычный CommonCrawl, ускоряющий сходимость моделей. Совпадает по размеру, собственно, тренировочным сетом Llama 3, хотя…

HF выложили датасет на 15 триллионов токенов — FineWeb 🍷— отфильтрованный моноязычный CommonCrawl, ускоряющий сходимость моделей. Совпадает по размеру, собственно, тренировочным сетом Llama 3, хотя…

👍1

The LLM ARChitect: Solving the ARC Challenge Is a Matter of Perspective https://github.com/da-fr/arc-prize-2024/blob/main/the_architects.pdf

GitHub

arc-prize-2024/the_architects.pdf at main · da-fr/arc-prize-2024

Our solution for the arc challenge 2024. Contribute to da-fr/arc-prize-2024 development by creating an account on GitHub.

👍2

Forwarded from Душный NLP

TDPO — потокенный DPO или просто регуляризация?

Авторы сегодняшней статьи предлагают метод потокенного Direct Preference Optimization (DPO), который на бумаге должен исправить некоторые проблемы оффлайн-обучения с подкреплением. Но на деле все оказывается не так просто.

DPO — метод обучения, не полагающийся на reward-модель. Здесь применяют датасет с размеченными парами запросов и ответов, чтобы натренировать генератор на контрастный лосс.

Проблема в том, что в случае с DPO мы работаем с вероятностями последовательностей целиком. Метод ограниченно контролирует поведение модели на уровне отдельных токенов. Это приводит к тому, что модель может ошибочно сильно повышать или понижать вероятность отдельных токенов значительно после совершенных ошибок.

Эту проблему можно нивелировать, если сделать DPO потокенным. Авторы статьи пытаются добиться этого.

Для начала они предлагают ввести необычное ограничение — сделать так, чтобы сумма наград всех токенов-продолжений для произвольного префикса была равна 0. Это довольно сильное допущение: например, если мы решаем задачу копирования какого-то куска текста, то будем сильно штрафовать модель за любое отклонение. Как результат — награда за правильный токен окажется очень большой. В этом случае, если при выборе между длинной и короткой строкой, модель будет склоняться к длинной строке.

Такое ограничение позволило авторам в их расчётах лосса избавиться от нормировочной константы вероятностного распределения. Чтобы ее вычислить, нужно суммировать награду по всем возможным ответам, а это невозможно, поэтому от константы при расчётах избавляются. В DPO нормировочная константа одинакова для победившего и проигравшего ответов, поэтому она сокращается в лоссе, но авторы статьи сделали это несколько иначе.

Из их математической модели выводится функция, которая очень похожа на DPO. Но в отличие от DPO, авторы вычитают из неё разницу между SeqKL проигравшего и победившего ответа. Этот метод, названный Token-level Direct Preference Optimization (TDPO), обеспечил незначительное улучшение по сравнению с обычным DPO. На датасете Anthropic HH точность увеличилась всего на 0,65%.

Далее авторы предлагают умножить на дополнительный коэффициент разницу SeqKL и не пропускать градиенты для победившего варианта. Это можно трактовать так: при росте SeqKL проигравшего ответа всегда увеличивается лосс, в то время, как при росте SeqKL победившего — лосс уменьшается. Получается, что добавка к DPO, после остановки градиента для её части, по сути работает, как регуляризация.

С ней метод получил название TDPO2 и он действительно неплохо улучшает показатели. На том же Anthropic HH прирост по сравнению с DPO составил уже не 0,65%, а 7,9%.

Авторы действительно предложили лучшее решение. Но возникает вопрос: насколько здесь велик вклад выведенной математической модели. По факту, авторы сильно меняют основные моменты в этой модели, а то, что остается, очень похоже на простую потокенную регуляризацию. Но её идея не нова: часто к DPO добавляют negative log likelihood loss — например, при DPO-обучении Llama 3.1, — что тоже является вариантом потокенной регуляризации. Мы склоняемся к тому, что научный вклад этой статьи невелик, а ключевые выводы — ошибочны.

Разбор подготовил❣ Михаил Хрущев

Душный NLP

Авторы сегодняшней статьи предлагают метод потокенного Direct Preference Optimization (DPO), который на бумаге должен исправить некоторые проблемы оффлайн-обучения с подкреплением. Но на деле все оказывается не так просто.

DPO — метод обучения, не полагающийся на reward-модель. Здесь применяют датасет с размеченными парами запросов и ответов, чтобы натренировать генератор на контрастный лосс.

Проблема в том, что в случае с DPO мы работаем с вероятностями последовательностей целиком. Метод ограниченно контролирует поведение модели на уровне отдельных токенов. Это приводит к тому, что модель может ошибочно сильно повышать или понижать вероятность отдельных токенов значительно после совершенных ошибок.

Эту проблему можно нивелировать, если сделать DPO потокенным. Авторы статьи пытаются добиться этого.

Для начала они предлагают ввести необычное ограничение — сделать так, чтобы сумма наград всех токенов-продолжений для произвольного префикса была равна 0. Это довольно сильное допущение: например, если мы решаем задачу копирования какого-то куска текста, то будем сильно штрафовать модель за любое отклонение. Как результат — награда за правильный токен окажется очень большой. В этом случае, если при выборе между длинной и короткой строкой, модель будет склоняться к длинной строке.

Такое ограничение позволило авторам в их расчётах лосса избавиться от нормировочной константы вероятностного распределения. Чтобы ее вычислить, нужно суммировать награду по всем возможным ответам, а это невозможно, поэтому от константы при расчётах избавляются. В DPO нормировочная константа одинакова для победившего и проигравшего ответов, поэтому она сокращается в лоссе, но авторы статьи сделали это несколько иначе.

Из их математической модели выводится функция, которая очень похожа на DPO. Но в отличие от DPO, авторы вычитают из неё разницу между SeqKL проигравшего и победившего ответа. Этот метод, названный Token-level Direct Preference Optimization (TDPO), обеспечил незначительное улучшение по сравнению с обычным DPO. На датасете Anthropic HH точность увеличилась всего на 0,65%.

Далее авторы предлагают умножить на дополнительный коэффициент разницу SeqKL и не пропускать градиенты для победившего варианта. Это можно трактовать так: при росте SeqKL проигравшего ответа всегда увеличивается лосс, в то время, как при росте SeqKL победившего — лосс уменьшается. Получается, что добавка к DPO, после остановки градиента для её части, по сути работает, как регуляризация.

С ней метод получил название TDPO2 и он действительно неплохо улучшает показатели. На том же Anthropic HH прирост по сравнению с DPO составил уже не 0,65%, а 7,9%.

Авторы действительно предложили лучшее решение. Но возникает вопрос: насколько здесь велик вклад выведенной математической модели. По факту, авторы сильно меняют основные моменты в этой модели, а то, что остается, очень похоже на простую потокенную регуляризацию. Но её идея не нова: часто к DPO добавляют negative log likelihood loss — например, при DPO-обучении Llama 3.1, — что тоже является вариантом потокенной регуляризации. Мы склоняемся к тому, что научный вклад этой статьи невелик, а ключевые выводы — ошибочны.

Разбор подготовил

Душный NLP

Please open Telegram to view this post

VIEW IN TELEGRAM

👍2

SLAck: Semantic, Location, and Appearance Aware Open-Vocabulary Tracking https://arxiv.org/abs/2409.11235

arXiv.org

SLAck: Semantic, Location, and Appearance Aware Open-Vocabulary Tracking

Open-vocabulary Multiple Object Tracking (MOT) aims to generalize trackers to novel categories not in the training set. Currently, the best-performing methods are mainly based on pure appearance...

OpenAI Email Archives (from Musk v. Altman) https://www.lesswrong.com/posts/5jjk4CDnj9tA7ugxr/openai-email-archives-from-musk-v-altman

Lesswrong

OpenAI Email Archives (from Musk v. Altman and OpenAI blog) — LessWrong

As part of the court case between Elon Musk and Sam Altman, a substantial number of emails between Elon, Sam Altman, Ilya Sutskever, and Greg Brockma…

👍1🤪1

Higher obstructions to conformal boundary conditions and lattice realizations https://arxiv.org/abs/2411.11757

arXiv.org

Higher obstructions to conformal boundary conditions and lattice...

Although it is long believed that vanishing of chiral central charges of a 2d conformal field theory (CFT) implies the existence of conformal boundary conditions, there are yet higher...

ChatGPT’s Poetry is Incompetent and Banal: A Discussion of (Porter and Machery, 2024) https://cs.nyu.edu/~davise/papers/GPT-Poetry.pdf

🔥3👍1😁1

BALROG: Benchmarking Agentic LLM and VLM Reasoning On Games https://arxiv.org/abs/2411.13543

arXiv.org

BALROG: Benchmarking Agentic LLM and VLM Reasoning On Games

Large Language Models (LLMs) and Vision Language Models (VLMs) possess extensive knowledge and exhibit promising reasoning abilities, however, they still struggle to perform well in complex,...

👍3❤1

First Results of Differential Doppler Positioning with Unknown Starlink Satellite Signals https://ieeexplore.ieee.org/document/9843493

Arithmetic Without Algorithms: Language Models Solve Math With a Bag of Heuristics https://arxiv.org/abs/2410.21272

arXiv.org

Arithmetic Without Algorithms: Language Models Solve Math With a...

Do large language models (LLMs) solve reasoning tasks by learning robust generalizable algorithms, or do they memorize training data? To investigate this question, we use arithmetic reasoning as a...

👍7

Most ideas still don't scale

https://fixupx.com/Yuchenj_UW/status/1861477701821047287

https://fixupx.com/Yuchenj_UW/status/1861477701821047287

FxTwitter / FixupX

Yuchen Jin (@Yuchenj_UW)

GPT-2 (1.6B) NanoGPT speedrun finished 🏃

Conclusion:

- Achieved 2X token efficiency compared to the llm.c baseline.

- Per single-step (~1M tokens), llm.c remains 26.9% faster on 8xH100s, I was wrong in my previous post.

- Wall-clock time: GPT-2 (1.6B) speedrun…

Conclusion:

- Achieved 2X token efficiency compared to the llm.c baseline.

- Per single-step (~1M tokens), llm.c remains 26.9% faster on 8xH100s, I was wrong in my previous post.

- Wall-clock time: GPT-2 (1.6B) speedrun…

😢3

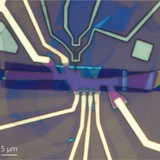

Non-Majorana-origin of the half-integer conductance quantization elucidated by multi-terminal superconductor-quantum anomalous Hall insulator heterostructure https://arxiv.org/abs/2411.14903

arXiv.org

Non-Majorana-origin of the half-integer conductance quantization...

Chiral one-dimensional transport can be realized in thin films of a surface-insulating ferromagnetic topological insulator called quantum anomalous Hall insulator (QAHI). When superconducting (SC)...

Algorithmic Collusion by Large Language Models https://arxiv.org/abs/2404.00806

arXiv.org

Algorithmic Collusion by Large Language Models

The rise of algorithmic pricing raises concerns of algorithmic collusion. We conduct experiments with algorithmic pricing agents based on Large Language Models (LLMs). We find that (1) LLM-based...

👍1

CutS3D: Cutting Semantics in 3D for 2D Unsupervised Instance Segmentation https://arxiv.org/abs/2411.16319

arXiv.org

CutS3D: Cutting Semantics in 3D for 2D Unsupervised Instance Segmentation

Traditionally, algorithms that learn to segment object instances in 2D images have heavily relied on large amounts of human-annotated data. Only recently, novel approaches have emerged tackling...

HyperSeg: Towards Universal Visual Segmentation with Large Language Model https://arxiv.org/abs/2411.17606

arXiv.org

HyperSeg: Towards Universal Visual Segmentation with Large Language Model

This paper aims to address universal segmentation for image and video perception with the strong reasoning ability empowered by Visual Large Language Models (VLLMs). Despite significant progress...

❤1

SAMWISE: Infusing wisdom in SAM2 for Text-Driven Video Segmentation https://arxiv.org/abs/2411.17646

arXiv.org

SAMWISE: Infusing Wisdom in SAM2 for Text-Driven Video Segmentation

Referring Video Object Segmentation (RVOS) relies on natural language expressions to segment an object in a video clip. Existing methods restrict reasoning either to independent short clips,...