ReferDINO-Plus: 2nd Solution for 4th PVUW MeViS Challenge at CVPR 2025 https://arxiv.org/abs/2503.23509

arXiv.org

ReferDINO-Plus: 2nd Solution for 4th PVUW MeViS Challenge at CVPR 2025

Referring Video Object Segmentation (RVOS) aims to segment target objects throughout a video based on a text description. This task has attracted increasing attention in the field of computer...

Evaluating progress of LLMs on scientific problem-solving https://research.google/blog/evaluating-progress-of-llms-on-scientific-problem-solving/

research.google

Evaluating progress of LLMs on scientific problem-solving

Hydrodynamics of the electronic Fermi liquid: a pedagogical overview https://arxiv.org/abs/2504.01249

arXiv.org

Hydrodynamics of the electronic Fermi liquid: a pedagogical overview

For over a hundred years, electron transport in conductive materials has been primarily described by the Drude model, which assumes that current flow is impeded primarily by momentum-relaxing...

Scene-Centric Unsupervised Panoptic Segmentation https://visinf.github.io/cups/

Flux attachment theory of fractional excitonic insulators https://arxiv.org/abs/2504.05427

arXiv.org

Flux attachment theory of fractional excitonic insulators

The search for fractional quantized Hall phases in the absence of a magnetic field has primarily targeted flat-band systems that mimic the features of a Landau level. In an alternative approach,...

❤1👍1

The 1st Solution for 4th PVUW MeViS Challenge: Unleashing the Potential of Large Multimodal Models for Referring Video Segmentation https://arxiv.org/abs/2504.05178

arXiv.org

The 1st Solution for 4th PVUW MeViS Challenge: Unleashing the...

Motion expression video segmentation is designed to segment objects in accordance with the input motion expressions. In contrast to the conventional Referring Video Object Segmentation (RVOS), it...

👍1

Signatures of unconventional superconductivity near reentrant and fractional quantum anomalous Hall insulators https://arxiv.org/abs/2504.06972

arXiv.org

Signatures of unconventional superconductivity near reentrant and...

Two-dimensional moiré Chern bands provide an exceptional platform for exploring a variety of many-body electronic liquid and solid phases at zero magnetic field within a lattice system. One...

Forwarded from Агенты ИИ | AGI_and_RL

Из реально прикольного пишут что автономный дрон из Micro Air Vehicle Lab Делфта обошел 13 других дронов, а еще обошел людей в гонках на A2RL Drone Championship в Абу Даби

Пару лет назад дрон уже обгонял людей, но там была предустановленная исследователями трасса. А в этой новости пишут, что трасса бала организаторами сделана (т.е. они или не затачивались под нее специально, или затачивались но не так сильно - тут я чот не очень понял).

RLем тренили

🥳 Оч круто

https://www.youtube.com/watch?v=yz2in2eFATE

https://www.tudelft.nl/2025/lr/wereldprimeur-tu-delft-ai-drone-wint-van-menselijke-bestuurders-op-wk-drone-racen

На ютубе на эту работу ссылаются

End-to-end Reinforcement Learning for Time-Optimal Quadcopter Flight

https://ieeexplore.ieee.org/document/10611665

https://arxiv.org/abs/2311.16948

PS Собираем кстати AI штуки и проекты делаем в https://www.tgoop.com/researchim

Пару лет назад дрон уже обгонял людей, но там была предустановленная исследователями трасса. А в этой новости пишут, что трасса бала организаторами сделана (т.е. они или не затачивались под нее специально, или затачивались но не так сильно - тут я чот не очень понял).

RLем тренили

https://www.youtube.com/watch?v=yz2in2eFATE

https://www.tudelft.nl/2025/lr/wereldprimeur-tu-delft-ai-drone-wint-van-menselijke-bestuurders-op-wk-drone-racen

На ютубе на эту работу ссылаются

End-to-end Reinforcement Learning for Time-Optimal Quadcopter Flight

https://ieeexplore.ieee.org/document/10611665

https://arxiv.org/abs/2311.16948

PS Собираем кстати AI штуки и проекты делаем в https://www.tgoop.com/researchim

Please open Telegram to view this post

VIEW IN TELEGRAM

YouTube

Autonomous Drone from TU Delft Defeats Human Champions in Historic Racing First

- https://www.linkedin.com/posts/tudelft_university-technology-innovation-ugcPost-7317863383142191105-hRgA?utm_source=share&utm_medium=member_desktop&rcm=ACoAAADJp08B9kdY-Ab21RQeBQVD_GoXFdPhx2c

- https://www.linkedin.com/posts/tu-delft-aerospace-engineering_aetudelft…

- https://www.linkedin.com/posts/tu-delft-aerospace-engineering_aetudelft…

👍3❤1😢1🫡1👾1

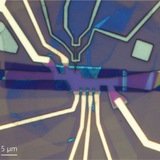

A RISC-V 32-bit microprocessor based on two-dimensional semiconductors https://www.nature.com/articles/s41586-025-08759-9

Nature

A RISC-V 32-bit microprocessor based on two-dimensional semiconductors

Nature - A RISC-V microprocessor capable of executing standard 32-bit instructions has been designed with 5,900 MoS2 transistors and a complete standard cell library based on 2D semiconductor...

🔥3👍2

Higher-Form Anomalies Imply Intrinsic Long-Range Entanglement https://arxiv.org/abs/2504.10569

arXiv.org

Higher-Form Anomalies Imply Intrinsic Long-Range Entanglement

We show that generic gapped quantum many-body states which respect an anomalous finite higher-form symmetry have an exponentially small overlap with any short-range entangled (SRE) state. Hence,...

Forwarded from AbstractDL

ignore-topk: новая регуляризация для борьбы с деградацией LLM во время файнтюнинга (by DeepMind)

При дообучении языковые модели частенько портятся. Рисёрчеры из DeepMind показали, что проблема связана с тем, что LLM, пытаясь запомнить новый факт, начинает использовать лёгкие shortcut-ы вместо аккуратного внедрения новых знаний в веса. Она просто «раскладывает» новую информацию по уже знакомым ей понятиям (казалось бы это хорошо, но нет). Такое явление они назвали "праймингом" (aka разложение числа на простые множители), и из-за него LLM начинает путаться в фактах, выдавая новую информацию где не просили.

Авторы этой статьи предлагают потенциальное решение — регуляризацию

- Делаем обычный шаг файнтюнинга и смотрим на обновления весов (Δω).

- Отбираем top-k% самых больших обновлений и… просто удаляем их (умножаем на 0).

- Используем только небольшие изменения весов, которые не содержат шорткатов для быстрой меморизации.

Зачем так странно?

Оказывается, самые большие градиенты как раз и отвечают за «грязное» быстрое запоминание через прайминг. Игнорируя их, мы заставляем модель учиться медленнее и аккуратнее. При этом прайминг уменьшается на 90-95%, а способность запоминать новые факты не страдает.

Но авторы конечно молодцы, сами придумали бенчмарк, сами свой подход измерили, а на другие "learning without forgetting" методы вообще забили. Поэтому не могу сказать, что

Статья

При дообучении языковые модели частенько портятся. Рисёрчеры из DeepMind показали, что проблема связана с тем, что LLM, пытаясь запомнить новый факт, начинает использовать лёгкие shortcut-ы вместо аккуратного внедрения новых знаний в веса. Она просто «раскладывает» новую информацию по уже знакомым ей понятиям (казалось бы это хорошо, но нет). Такое явление они назвали "праймингом" (aka разложение числа на простые множители), и из-за него LLM начинает путаться в фактах, выдавая новую информацию где не просили.

Авторы этой статьи предлагают потенциальное решение — регуляризацию

ignore-topk. Идея до гениальности простая:- Делаем обычный шаг файнтюнинга и смотрим на обновления весов (Δω).

- Отбираем top-k% самых больших обновлений и… просто удаляем их (умножаем на 0).

- Используем только небольшие изменения весов, которые не содержат шорткатов для быстрой меморизации.

Зачем так странно?

Оказывается, самые большие градиенты как раз и отвечают за «грязное» быстрое запоминание через прайминг. Игнорируя их, мы заставляем модель учиться медленнее и аккуратнее. При этом прайминг уменьшается на 90-95%, а способность запоминать новые факты не страдает.

Но авторы конечно молодцы, сами придумали бенчмарк, сами свой подход измерили, а на другие "learning without forgetting" методы вообще забили. Поэтому не могу сказать, что

ignore-topk лучше чем, например, Child-Tuning или EWC, но выглядит прикольно, я его точно попробую 🤷♂️Статья

👍18❤5🔥1🤮1