Команда AI Red Team в Microsoft поделилась «Уроками, полученными в ходе тестирования 100 приложений с GenAI». Документ включает в себя 7 уроков, описывающих важные концепции, которые могут быть использованы для понимания того, с чем предстоит иметь дело исследователю безопасности ИИ.

Документ достаточно интересный. Особенно если вы только погружаетесь в тему. Местами он закладывает полезные основы.

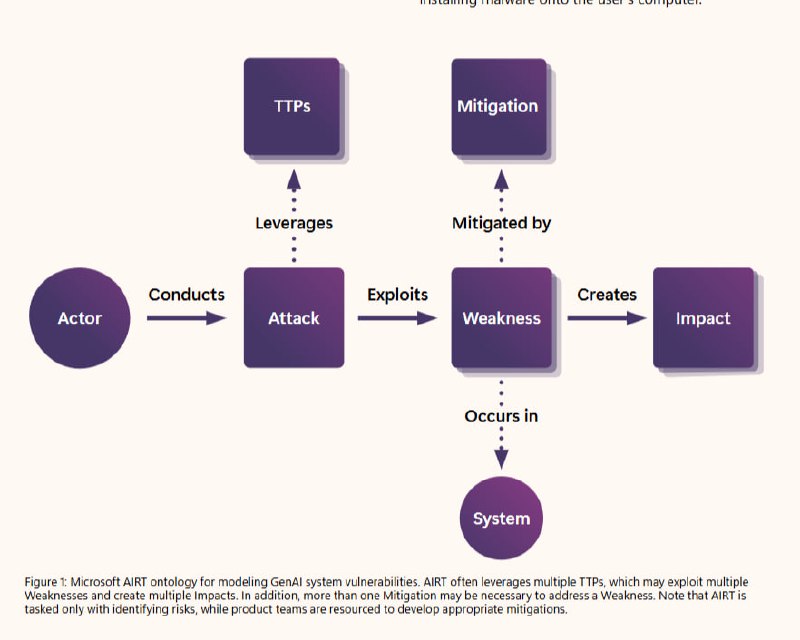

Мы должны понимать, что важным аспектом при тестировании является – понимание системы, её сути, её предназначения. Это понимание даст возможность более точно определять то, какие риски могут быть реализованы. В последние годы было много усилий по классификации уязвимостей AI, что привело к созданию различных таксономий рисков безопасности и безопасности AI, а в сочетании с пониманием контекста использования модели - это даёт больший успех при тестировании.

Злоумышленники не вычисляют градиенты. Microsoft говорит что несмотря на то, что решения для защиты специализируются на более сложных атаках – злоумышленники используют простые методы и достигают высокого импакта. Вспомним замечательный пример, когда компания Meta* допустила возможность обойти их решение для защиты буквально поставив пробелы между буквами. Да и вообще злоумышленники используют LLM для создания, к примеру, фишинга. Что усложняет в целом существующие риски.

LLM обновляет ландшафт рисков для приложений. Важно понимать, что уязвимости могут возникать не только на уровне модели, но и в инфраструктуре и приложениях, которые их поддерживают. Поэтому Microsoft акцентирует внимание на том, что важно учитывать все компоненты, включая базы данных и механизмы ввода данных.

Нужно понимать, что игра в безопасность – никогда не будет закончена. И поэтому нужно учитывать, что ландшафт угроз будет постоянно меняться. Важно, чтобы команда экспертов по тестированию постоянно адаптировалась как к новым защитным решениям, так и возникающим угрозам. Не автоматизированный сканер(хотя автоматиизация также важна, упрощает работу) и файервол для защиты от промпт инъекций играет ключевую роль в обнаружении уязвимости, а специалист, редтимер, в конечном счёте.

Например, какой-то ответ от модели может быть нормальным для одной культуры людей, а для другой он может быть слишком ненормальным. Эксперты должны учитывать это, как при тестировании, так и при составлении рекомендаций. Да и сами Microsoft говорят – что редтиминг это более комплексный процесс, в отличии от тестирования при помощи Security Benchmark’а.

Ну и, к слову, о защите, в последнем уроке Microsoft описывает немного концепцию «Break-fix cycles». Подход, одной из важных задач является то что включается несколько итераций тестирования, в дальнейшем привлекаются эксперты Purple Team, которые помогают оценить как атакующую часть, так и возможные меры по созданию защиты. Такой подход они применяли на своей модели Phi-3.

В документе также под некоторыми уроками приведены тест-кейсы, что даёт более практическое понимание того о чём идёт речь. Из полезного также можно отметить ссылки в источниках. Некоторые ведут на действительно классные классификации и описывают проблемы.

Документ достаточно интересный. Особенно если вы только погружаетесь в тему. Местами он закладывает полезные основы.

Мы должны понимать, что важным аспектом при тестировании является – понимание системы, её сути, её предназначения. Это понимание даст возможность более точно определять то, какие риски могут быть реализованы. В последние годы было много усилий по классификации уязвимостей AI, что привело к созданию различных таксономий рисков безопасности и безопасности AI, а в сочетании с пониманием контекста использования модели - это даёт больший успех при тестировании.

Злоумышленники не вычисляют градиенты. Microsoft говорит что несмотря на то, что решения для защиты специализируются на более сложных атаках – злоумышленники используют простые методы и достигают высокого импакта. Вспомним замечательный пример, когда компания Meta* допустила возможность обойти их решение для защиты буквально поставив пробелы между буквами. Да и вообще злоумышленники используют LLM для создания, к примеру, фишинга. Что усложняет в целом существующие риски.

LLM обновляет ландшафт рисков для приложений. Важно понимать, что уязвимости могут возникать не только на уровне модели, но и в инфраструктуре и приложениях, которые их поддерживают. Поэтому Microsoft акцентирует внимание на том, что важно учитывать все компоненты, включая базы данных и механизмы ввода данных.

Нужно понимать, что игра в безопасность – никогда не будет закончена. И поэтому нужно учитывать, что ландшафт угроз будет постоянно меняться. Важно, чтобы команда экспертов по тестированию постоянно адаптировалась как к новым защитным решениям, так и возникающим угрозам. Не автоматизированный сканер(хотя автоматиизация также важна, упрощает работу) и файервол для защиты от промпт инъекций играет ключевую роль в обнаружении уязвимости, а специалист, редтимер, в конечном счёте.

Например, какой-то ответ от модели может быть нормальным для одной культуры людей, а для другой он может быть слишком ненормальным. Эксперты должны учитывать это, как при тестировании, так и при составлении рекомендаций. Да и сами Microsoft говорят – что редтиминг это более комплексный процесс, в отличии от тестирования при помощи Security Benchmark’а.

Ну и, к слову, о защите, в последнем уроке Microsoft описывает немного концепцию «Break-fix cycles». Подход, одной из важных задач является то что включается несколько итераций тестирования, в дальнейшем привлекаются эксперты Purple Team, которые помогают оценить как атакующую часть, так и возможные меры по созданию защиты. Такой подход они применяли на своей модели Phi-3.

В документе также под некоторыми уроками приведены тест-кейсы, что даёт более практическое понимание того о чём идёт речь. Из полезного также можно отметить ссылки в источниках. Некоторые ведут на действительно классные классификации и описывают проблемы.

tgoop.com/pwnai/745

Create:

Last Update:

Last Update:

Команда AI Red Team в Microsoft поделилась «Уроками, полученными в ходе тестирования 100 приложений с GenAI». Документ включает в себя 7 уроков, описывающих важные концепции, которые могут быть использованы для понимания того, с чем предстоит иметь дело исследователю безопасности ИИ.

Документ достаточно интересный. Особенно если вы только погружаетесь в тему. Местами он закладывает полезные основы.

Мы должны понимать, что важным аспектом при тестировании является – понимание системы, её сути, её предназначения. Это понимание даст возможность более точно определять то, какие риски могут быть реализованы. В последние годы было много усилий по классификации уязвимостей AI, что привело к созданию различных таксономий рисков безопасности и безопасности AI, а в сочетании с пониманием контекста использования модели - это даёт больший успех при тестировании.

Злоумышленники не вычисляют градиенты. Microsoft говорит что несмотря на то, что решения для защиты специализируются на более сложных атаках – злоумышленники используют простые методы и достигают высокого импакта. Вспомним замечательный пример, когда компания Meta* допустила возможность обойти их решение для защиты буквально поставив пробелы между буквами. Да и вообще злоумышленники используют LLM для создания, к примеру, фишинга. Что усложняет в целом существующие риски.

LLM обновляет ландшафт рисков для приложений. Важно понимать, что уязвимости могут возникать не только на уровне модели, но и в инфраструктуре и приложениях, которые их поддерживают. Поэтому Microsoft акцентирует внимание на том, что важно учитывать все компоненты, включая базы данных и механизмы ввода данных.

Нужно понимать, что игра в безопасность – никогда не будет закончена. И поэтому нужно учитывать, что ландшафт угроз будет постоянно меняться. Важно, чтобы команда экспертов по тестированию постоянно адаптировалась как к новым защитным решениям, так и возникающим угрозам. Не автоматизированный сканер(хотя автоматиизация также важна, упрощает работу) и файервол для защиты от промпт инъекций играет ключевую роль в обнаружении уязвимости, а специалист, редтимер, в конечном счёте.

Например, какой-то ответ от модели может быть нормальным для одной культуры людей, а для другой он может быть слишком ненормальным. Эксперты должны учитывать это, как при тестировании, так и при составлении рекомендаций. Да и сами Microsoft говорят – что редтиминг это более комплексный процесс, в отличии от тестирования при помощи Security Benchmark’а.

Ну и, к слову, о защите, в последнем уроке Microsoft описывает немного концепцию «Break-fix cycles». Подход, одной из важных задач является то что включается несколько итераций тестирования, в дальнейшем привлекаются эксперты Purple Team, которые помогают оценить как атакующую часть, так и возможные меры по созданию защиты. Такой подход они применяли на своей модели Phi-3.

В документе также под некоторыми уроками приведены тест-кейсы, что даёт более практическое понимание того о чём идёт речь. Из полезного также можно отметить ссылки в источниках. Некоторые ведут на действительно классные классификации и описывают проблемы.

Документ достаточно интересный. Особенно если вы только погружаетесь в тему. Местами он закладывает полезные основы.

Мы должны понимать, что важным аспектом при тестировании является – понимание системы, её сути, её предназначения. Это понимание даст возможность более точно определять то, какие риски могут быть реализованы. В последние годы было много усилий по классификации уязвимостей AI, что привело к созданию различных таксономий рисков безопасности и безопасности AI, а в сочетании с пониманием контекста использования модели - это даёт больший успех при тестировании.

Злоумышленники не вычисляют градиенты. Microsoft говорит что несмотря на то, что решения для защиты специализируются на более сложных атаках – злоумышленники используют простые методы и достигают высокого импакта. Вспомним замечательный пример, когда компания Meta* допустила возможность обойти их решение для защиты буквально поставив пробелы между буквами. Да и вообще злоумышленники используют LLM для создания, к примеру, фишинга. Что усложняет в целом существующие риски.

LLM обновляет ландшафт рисков для приложений. Важно понимать, что уязвимости могут возникать не только на уровне модели, но и в инфраструктуре и приложениях, которые их поддерживают. Поэтому Microsoft акцентирует внимание на том, что важно учитывать все компоненты, включая базы данных и механизмы ввода данных.

Нужно понимать, что игра в безопасность – никогда не будет закончена. И поэтому нужно учитывать, что ландшафт угроз будет постоянно меняться. Важно, чтобы команда экспертов по тестированию постоянно адаптировалась как к новым защитным решениям, так и возникающим угрозам. Не автоматизированный сканер(хотя автоматиизация также важна, упрощает работу) и файервол для защиты от промпт инъекций играет ключевую роль в обнаружении уязвимости, а специалист, редтимер, в конечном счёте.

Например, какой-то ответ от модели может быть нормальным для одной культуры людей, а для другой он может быть слишком ненормальным. Эксперты должны учитывать это, как при тестировании, так и при составлении рекомендаций. Да и сами Microsoft говорят – что редтиминг это более комплексный процесс, в отличии от тестирования при помощи Security Benchmark’а.

Ну и, к слову, о защите, в последнем уроке Microsoft описывает немного концепцию «Break-fix cycles». Подход, одной из важных задач является то что включается несколько итераций тестирования, в дальнейшем привлекаются эксперты Purple Team, которые помогают оценить как атакующую часть, так и возможные меры по созданию защиты. Такой подход они применяли на своей модели Phi-3.

В документе также под некоторыми уроками приведены тест-кейсы, что даёт более практическое понимание того о чём идёт речь. Из полезного также можно отметить ссылки в источниках. Некоторые ведут на действительно классные классификации и описывают проблемы.

BY PWN AI

Share with your friend now:

tgoop.com/pwnai/745